Telegram 创办人宣布「AI 算力网路 Cocoon」上线:可用 GPU 挖 TON、100% 隐私运算

Telegram 创办人宣布 Cocoon 去中心化算力网路上线:主打让边缘算力解决需求、100% 隐私,让 GPU 持有者可出租算力赚取 TON,挑战云端巨头垄断。

(前情提要:Telegram创办人Pavel Durov警告:自由网路濒危,监控时代吞噬数位自由)

(背景补充:快讯》Telegram 创办人 Pavel Durov 获准离开法国,TON 急速跳涨 20%)

本文目录

Telegram 创办人 Pavel Durov 昨(1)日宣布心野心之作:Cocoon (Confidential Compute Open Network) 正式宣布主网上线。

标志着 Telegram 生态系正式跨足 AI 基础设施领域,并向 Amazon AWS 和 Microsoft Azure 等中心化云端巨头发起直接挑战。

Durov 在公告中自豪地表示:

它发生了。我们的去中心化机密运算网路 Cocoon 已经上线。来自使用者的首批 AI 请求正以 100% 的机密性由 Cocoon 处理中,而 GPU 持有者也已经开始赚取 TON。

什么是 Cocoon?不只是「另一个」去中心化网路

Cocoon 是一个建立在 TON 网路之上的去中心化实体基础设施网路。其核心愿景是解决当前 AI 发展的两大痛点:昂贵的运算成本与数据隐私的丧失。

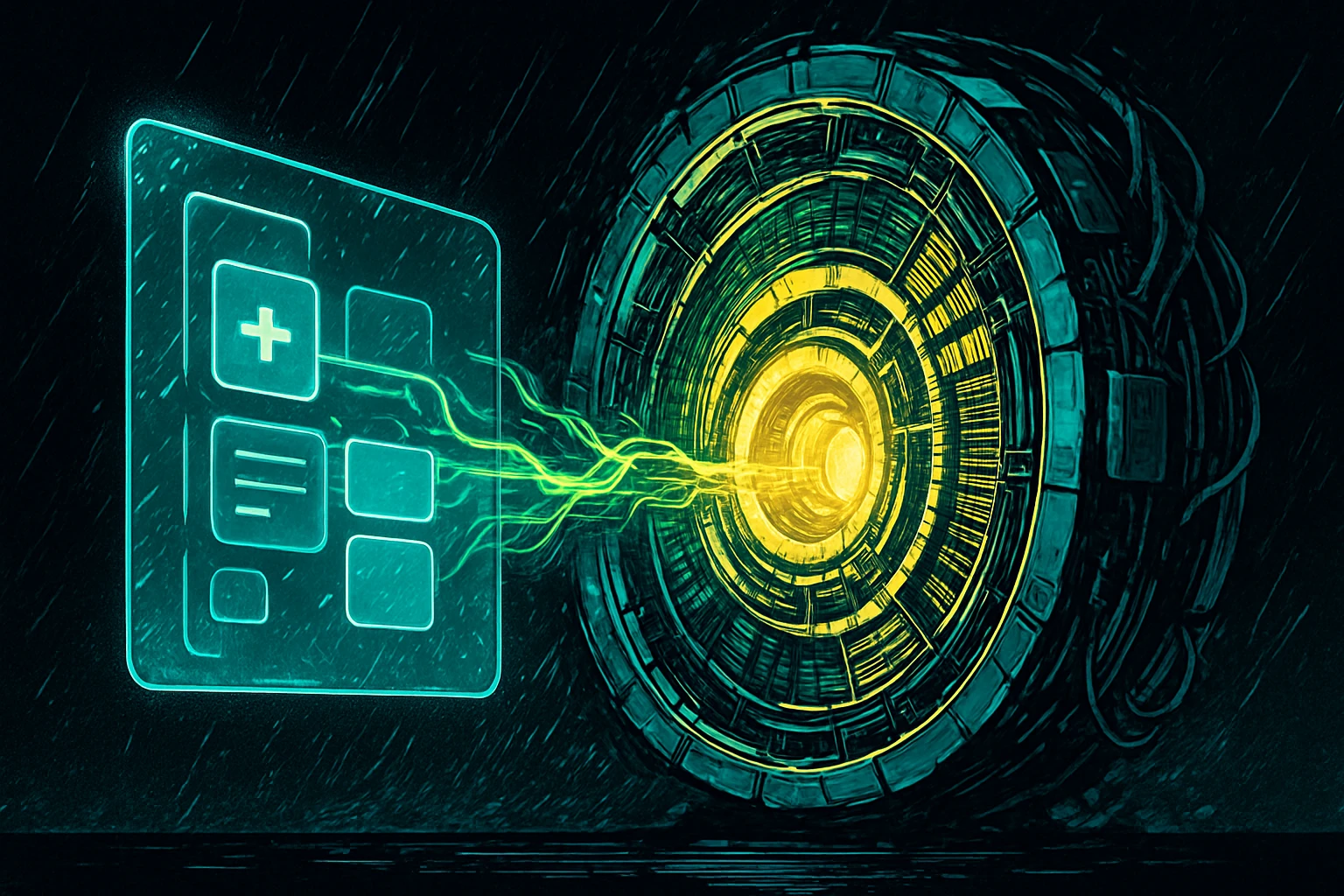

不同于传统云端服务将数据传送至中心化伺服器处理,Cocoon 媒合了两端的需求:

算力需求方(AI 开发者):需要便宜且安全的算力来运行 AI 模型。

算力提供方(GPU 持有者):拥有闲置的高效能显示卡(GPU),希望能透过出租算力获利。

核心技术:如何在「不信任」中建立「信任」?

根据官方说明,Cocoon 有以下两大特色:

100% 隐私保护:透过受信任执行环境(TEEs,如 Intel TDX 等技术),Cocoon 确保 AI 运算的过程是在一个加密的「黑盒子」中进行。这意味着,即便是提供算力的 GPU 矿工,也无法查看或拦截其硬体上正在处理的数据或 AI 模型内容。

去中心化架构:没有单一的中介机构控制数据流向,从根本上杜绝了像科技巨头那样滥用使用者数据训练模型或进行审查的可能性。

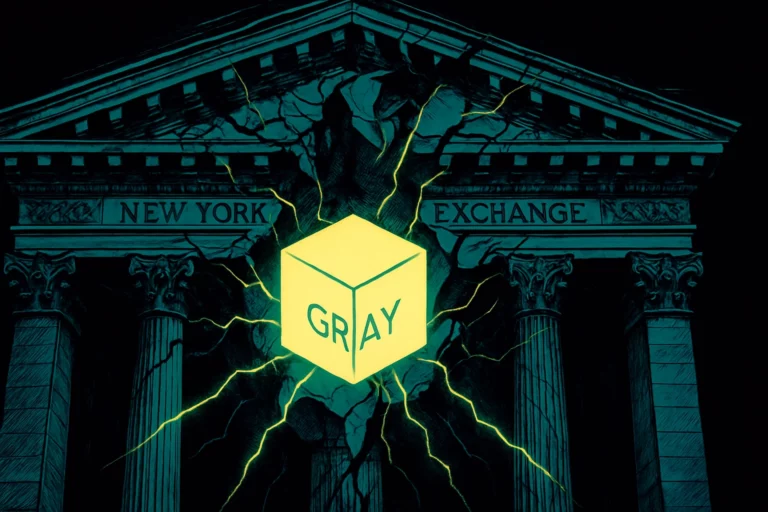

对抗科技巨头:打破 Amazon 与 Microsoft 的垄断

Pavel Durov 在公告中直言不讳地提出挑战:「Amazon 和 Microsoft 等中心化运算提供商充当了昂贵的中介,推高了价格并降低了隐私。」

Cocoon 试图通过市场机制来打破这种垄断。藉由去中心化的竞价模式,开发者有望获得比传统云端更低廉的推理成本,而透过 TON 作为结算层,确保全球 GPU 提供者能获得即时且透明的收益。

生态系整合:Telegram 是最大后援

Cocoon 的诞生就有富爸爸,背后拥有 Telegram 超过 10 亿用户作为支撑。

Telegram Mini Apps 赋能:未来的 Telegram 机器人与小程序,有望能直接调用 Cocoon 的算力,实现「隐私优先」的 AI 功能(如私密聊天机器人、文档分析等)。

GPU 挖矿:对于拥有消费级高阶显卡(如 NVIDIA RTX 4090)或企业级显卡(如 H100, A100)的用户来说,Cocoon 提供了一个新的挖矿途径,透过贡献算力赚取 TON 代币。

正如 Durov 所言:「Cocoon 想把控制权和隐私带回它们所属的地方:用户手中。」不过说实话,如何透过边缘算力解决 AI 算力需求,在落地执行上,还有很多需要解决的痛点,能否实现其远大的愿景,还有待时间观察。